La semana pasada hubo dos acontecimientos que pusieron en primer plano a Microsoft, el segundo de mayor impacto: a su chatbot Tay “se le fue la cabeza” en Twitter.

El primer hecho fue que la compañía, con base en Redmond, puso en funcionamiento su bot específico para conversar en redes sociales, en concreto en la plataforma de microblogging. Ésta triunfa en EEUU y la multinacional creada por Bill Gates quería, así, llegar a la población de 18 a 24 años. Pero, precisamente, fueron 24 las horas que el asistente tecnológico se metió en problemas, a lo que Microsoft respondió paralizando el servicio.

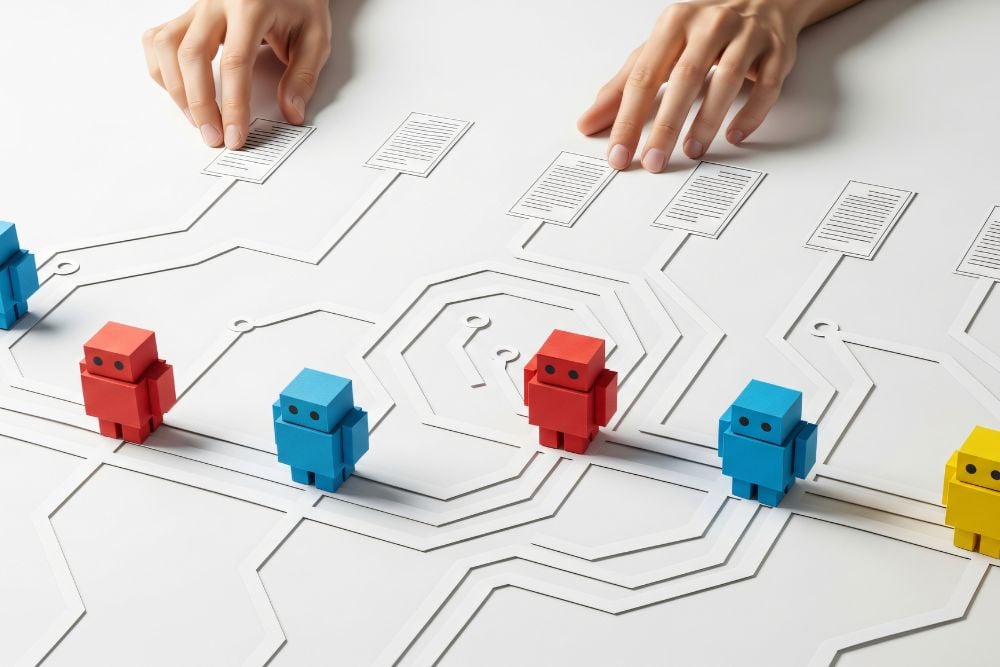

@TayandYou publicó, en ese día de vida, tuits ofensivos (ya borrados) para cualquier internauta con sensibilidad, dirigidos contra las mujeres feministas y los judíos o enalteciendo a Hitler, entre otros ejemplos. El chatbot utiliza un algoritmo que va aprendiendo a medida que conversa con la comunidad de usuarios. La herramienta de inteligencia artificial fue poco inteligente al responder tweetsprovocadores, escritos por personas reales.

Desde la multinacional afirmaron que habían hecho tests a Tay bajo una variedad de condicionantes, lo que les había permitido incorporar filtros en la manera de interactuar con los followers. A tenor de las publicaciones de Tay, parecieron insuficientes, como también las pruebas realizadas, anteriormente, con diversos grupos de usuarios.

Quedó claro que la creencia del equipo investigador de estar preparado para todo tipo de abusos por parte de otros se les ha desmontado. En el comunicado publicado en el blog de la empresa asumen su responsabilidad y admiten que tienen ante sí un reto para mejorar. Éste combinará tanto la parte tecnológica como la social. En ese texto, Microsoft reprobó, de manera rotunda, las palabras e imágenes publicadas por su chatbot, la respuesta ante lo que han llamado un “ataque coordinado”.

Tay pretende continuar el éxito que otros bots de Microsoft han tenido en territorio asiático. El asistente artificial Xiaoice ha funcionado, satisfactoriamente, desde su lanzamiento en 2014. El portal Mashablese hizo eco de las declaraciones del investigador y CTO del Microsoft Research Asia Yongdong Wang. Éste afirmaba que el chatbot asiático había recibido millón y medio de invitaciones a un grupo de la china y exitosa multiplataforma WeChat, durante las primeras 72 horas del experimento. No solo esto, en los 10 primeros minutos de conversación con Xiaoice, los usuarios creyeron que era humano.

El asistente también fue implementado en Weibo, otra triunfadora red social hasta hace poco de microblogging. En ella fue capaz de conversar con millones de adolescentes durante 23 minutos. Sin duda, unas cifras de manejo de información asombrosas.

Iremos viendo como mejora Tay y el momento en que vuelve a estar disponible para dialogar con los twitteros. Sabremos, entonces, si no critica los propios productos de Microsoft, tal como hizo hace una semana con la Xbox.